티스토리 뷰

[논문 리뷰] 추론 모델과 COT를 이해하면서, 애플의 The Illusion of Thinking 논문 초록 읽기

jhin.lee 2025. 6. 19. 16:04올해 6월 초, 애플은 꽤 공격적인 제목의 새로운 논문을 발표합니다.

The Illusion of Thinking:Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity

생각이라는 환상: 문제 복잡성의 관점에서 추론 모델의 강점과 한계를 이해하기

즉 논문 제목에서 강조하고 싶은 내용은

추론 모델(Reasoning Model)이 생각(Thingking)을 한다는 것은 착각(Illusion)이다. 라는 말이겠죠.

이 논문 발표가 어떻게 뉴스화 되었는지 보시죠.

논문을 토대로 현재의 AI에 회의를 나타내는 기사들과

애플의 논문 발표는 타 기업에 대한 견제일 뿐이다. 라는 크게 두가지 입장으로 분리되는 것 같습니다.

실제 논문이 어떤 내용을 담고 있는지 일부 내용을 이해하면서 알아보도록 하겠습니다.

Abstract(초록)의 첫 번째 문장

Recent generations of frontier language models have introduced Large Reasoning Models (LRMs) that generate detailed thinking processes before providing answers. While these models demonstrate improved performance on reasoning benchmarks, their fundamental capabilities, scaling properties, and limitations remain insufficiently understood.

최신 세대의 최첨단 언어 모델들은, 정답을 제시하기 전에 구체적인 사고 과정을 생성하는 대형 추론 모델(LRMs)을 도입하였습니다. 이러한 모델들은 추론 벤치마크에서 향상된 성능을 보여주지만, 이들의 근본적인 능력, 확장 특성, 그리고 한계는 여전히 충분히 이해되지 않고 있습니다.

AI에 대한 공부를 할 때 개인적으로 중요하게 신경을 쓰는것은,

자연어로도 쓰이는 단어가 기술적으로 쓰일때, 오해해서 이해하지 않도록 주의를 기울이는 것입니다.

Reasoning 이라는 단어는 보통 추론이라고 번역됩니다.

추론 이라는 단어를 국어사전에서 찾아보면

추론(推論)

「1」 미루어 생각하여 논함.

추론은 사실에 근거해야 한다.

확실한 증거가 없이 추론에 의해서만 결론을 내리는 것은 위험하다.

「2」 『철학』 어떠한 판단을 근거로 삼아 다른 판단을 이끌어 냄. ≒추리.

자연어로는 위와 같은 뜻을 가지고 있다고 볼 수 있습니다.

그렇다면 기계학습에서 추론은 어떤 의미의 단어로 쓰이고 있는 걸까요?

애플의 논문을 마저 읽기 전에 잠시 딴길로 세어,

Reasoning 이라는 용어가 어떤 의미로 쓰이고 있는지 알면 좋을 것 같습니다.

Reasoning

OpenAI에서 o1 모델을 발표하면서 함께 발표한 이 논문을 같이 보면 좋을 것 같습니다.

Learning to reason with LLMs

LLM으로 추론하는 법 배우기

We are introducing OpenAI o1, a new large language model trained with reinforcement learning to perform complex reasoning. o1 thinks before it answers—it can produce a long internal chain of thought before responding to the user.

우리는 복잡한 추론을 수행하도록 강화 학습을 통해 훈련된 새로운 대형 언어 모델, OpenAI o1을 소개합니다. o1은 답변하기 전에 먼저 생각합니다—사용자에게 응답하기 전에 긴 내부적인 사고 과정을 생성할 수 있습니다.

OpenAI가 o1 모델을 발표하면서 강조한 성능이 바로 추론 기능입니다.

위 설명문에서 제가 추론(저도 추론 하네요) 해볼 수 있는 내용은,

1. new large language model trained with reinforcement learning

→ OpenAI의 o1이 강화학습을 통해 훈련된 LLM이라는 점

2. can produce a long internal chain of thought before responding

→ 응답 전, 내부적으로 COT를 생성한다는 점

입니다.

강화 학습에 대해서는 뒤에 다시 한번 말 하겠지만,

Chain Of Thought (COT)를 간단하게 설명 하고 넘어가야 될 것 같습니다.

Chain Of Thought

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

사고의 사슬을 자극하여 대규모 언어 모델에서 추론을 이끌어내기

이 논문에서 소개된 사고의 사슬 (이후에는 COT라고 하겠습니다.) 은 프롬프팅 기술입니다.

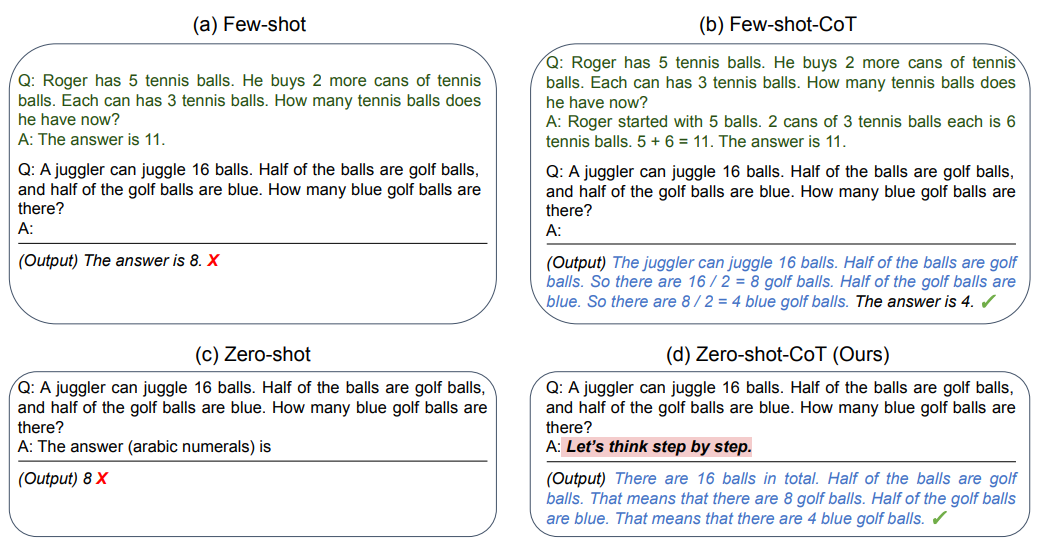

논문에 삽입된 이미지를 같이 보시면 이해가 바로 될 것 같습니다.

Model Input을 보면, QnA 예시를 들고 비슷한 형식의 다른 질문을 하는것을 볼 수 있습니다.

이 예시에서 COT 프롬프팅은 QnA 예시에서 정답 뿐 아니라 정답에 이르는 과정을 함께 적어내는데요. (파랗게 칠한 부분)

이 과정을 통해서 LLM의 응답 또한 풀이를 적게 유도하고 그 결과 정답에 이르게 될 가능성이 높아지게 됩니다.

COT의 연구 중에서 대중들에게 익숙한 것은, 제로샷 COT 라고 불리는 방법이 있습니다.

Let's think step by step. (단계적으로 생각해보자) 라고 한문장을 추가하면 Reasoning이 이루어진다는 연구입니다.

LRM(추론모델)이란 무엇인가 정리

아까 정리 했던 OpenAI o1 모델의 특징을 다시 살펴보겠습니다.

1. new large language model trained with reinforcement learning

→ OpenAI의 o1이 강화학습을 통해 훈련된 LLM이라는 점

2. can produce a long internal chain of thought before responding

→ 응답 전, 내부적으로 COT를 생성한다는 점

즉, 추론 모델이란 아래와 같이 풀어서 이해해볼 수 있을 것 같습니다.

단답형 응답 대신, 절차적·단계적으로 문제를 해결하는 방식으로 응답하도록 학습된 AI 모델

몇 가지 알려진 방법론으로는 COT를 생성하거나, 절차적 응답에 보상을 주는 방식으로 강화학습이 적용된 LLM이다.

라고 생각 하면 될 것 같습니다.

다시 The Illusion of Thinking 논문의 나머지 초록 번역

Current evaluations primarily focus on established mathematical and coding benchmarks, emphasizing final answer accuracy. However, this evaluation paradigm often suffers from data contamination and does not provide insights into the reasoning traces’ structure and quality.

기존 평가 방식은 주로 수학 및 코딩 벤치마크에 초점을 맞추고 최종 정답의 정확도만을 강조합니다. 그러나 이러한 평가 방식은 데이터 오염에 취약하며, 추론 과정의 구조와 품질에 대한 통찰을 제공하지 못합니다.

In this work, we systematically investigate these gaps with the help of controllable puzzle environments that allow precise manipulation of compositional complexity while maintaining consistent logical structures. This setup enables the analysis of not only final answers but also the internal reasoning traces, offering insights into how LRMs “think.”

이 연구에서는 복잡성을 정밀하게 조작하면서도 논리 구조는 유지하는 통제 가능한 퍼즐 환경을 활용하여 이러한 평가의 공백을 체계적으로 조사합니다. 이 설정은 최종 답변뿐만 아니라 내부 사고 과정 까지도 분석할 수 있게 하여, LRM이 어떻게 "생각"하는지를 이해할 수 있는 통찰을 제공합니다.

Through extensive experimentation across diverse puzzles, we show that frontier LRMs face a complete accuracy collapse beyond certain complexities. Moreover, they exhibit a counterintuitive scaling limit: their reasoning effort increases with problem complexity up to a point, then declines despite having an adequate token budget.

광범위한 실험을 통해, LRM은 특정 복잡도를 넘으면 정확도가 완전히 붕괴된다는 사실을 확인했습니다. 더욱이 직관에 반하는 스케일링 한계를 나타냈습니다: 문제 복잡도가 증가할수록 추론 노력(token 사용량)은 올라가다가, 정작 토큰 예산이 남아 있음에도 일정 지점 이후에는 오히려 감소합니다.

By comparing LRMs with their standard LLM counterparts under equivalent inference compute, we identify three performance regimes:

(1) low-complexity tasks where standard models surprisingly outperform LRMs,

(2) medium-complexity tasks where additional thinking in LRMs demonstrates advantage, and

(3) high-complexity tasks where both models experience complete collapse.

또한 동일한 추론 계산량 조건 아래, LRM과 일반 LLM을 비교한 결과 세 가지 성능 구간이 존재함을 발견했습니다:

(1) 낮은 복잡도: 일반 LLM이 LRM보다 더 잘 작동

(2) 중간 복잡도: LRM의 추가적인 '사고'가 유리하게 작용

(3) 높 복잡도: 두 모델 모두 완전 붕괴

We found that LRMs have limitations in exact computation: they fail to use explicit algorithms and reason inconsistently across puzzles. We also investigate the reasoning traces in more depth, studying the patterns of explored solutions and analyzing the models’ computational behavior, shedding light on their strengths, limitations, and ultimately raising crucial questions about their true reasoning capabilities.

LRM은 정확한 계산 능력에도 한계를 보였습니다. 명시적 알고리즘을 활용하지 못하고, 퍼즐마다 일관되지 않은 추론을 수행했습니다. 또한 사고 과정을 보다 깊이 분석함으로써, 탐색된 해법들의 패턴과 모델의 계산적 행동을 연구했습니다. 이를 통해 LRM의 강점과 한계를 조명하고, 그들의 진정한 추론 능력에 대한 중요한 의문을 제기합니다.

요약

이 논문은 기존 LRM 모델들 (구체적으로 OpenAI’s o1/o3, DeepSeek-R1, Claude 3.7 Sonnet Thinking, and Gemini Thinking)에 대해서, 기존 수학 및 코딩 위주의 벤치마크 평가 방식에 문제를 제기합니다. 기존 벤치마크 평가 방식은 데이터 오염에 취약하고 추론 과정의 품질에 대한 통찰을 제공하지 않는다고 평가합니다.

(데이터 오염에 취약하다는 뜻은, 벤치마크에 쓰인 문제들이 이미 모델의 학습에 쓰였을 가능성이 높다는 뜻입니다.)

그 대안으로 연구자들은 몇가지 퍼즐을 통한 벤치마크를 제안하고 실험 결과를 공유 하고 있습니다.

그 퍼즐들은 아래와 같습니다.

이 퍼즐을 통해 실험한 결과 연구진이 얻은 몇가지 통찰은 다음과 같습니다.

1. 문제 복잡도가 증가할수록 추론 노력(토큰 사용량)이 올라가다가, 토큰이 남아 있음에도 일정 지점 이후에는 오히려 감소한다는 사실. (답변을 포기하는 현상)

2. LRM은 특정 복잡도를 넘으면 정확도가 완전히 붕괴된다는 사실

3. 명시적 알고리즘을 활용하지 못하고, 퍼즐마다 일관되지 않은 추론을 수행

- 프롬프트에 퍼즐 해결을 하기 위한 알고리즘을 함께 줘도 해결하지 못했다는 뜻입니다.

4. LRM과 일반 LLM을 비교한 결과 세 가지 성능 구간이 존재

(1) 낮은 복잡도: 일반 LLM이 LRM보다 더 잘 작동

(2) 중간 복잡도: LRM의 추가적인 '사고'가 유리하게 작용

(3) 높 복잡도: 두 모델 모두 완전 붕괴

고찰

논문 제목이 "통제 가능한 퍼즐 환경을 활용한 LRM 벤치마크 방법론 제시"

였다면 이정도 까지 이슈가 되지는 않았을 것 같습니다.

논문 자체의 내용은 연구자들에게 비판받을 점도, 공감받을 점도 있을 수 있다고 생각하지만

타사 AI를 구체적으로 언급하면서 자극적인 제목으로 발표한 논문에

WWDC 직전이라는 발표 시기, 그리고 WWDC에서 애플의 AI 관련 발표가 혹평을 받은 것을 생각하면.

다분히 타사 AI를 까내리기 위한 의도적인 부분이 있다고 의심 받는것도 당연한 것 같습니다.

'Study > AI, ML' 카테고리의 다른 글

| QLoRA: Efficient Finetuning of Quantized LLMs - Abstract, Background (2) | 2024.06.14 |

|---|---|

| OpenAI, LLM, ChatGPT (2) | 2024.06.12 |